转自:《金融电子化杂志》2019年12月刊

文||海通证券股份有限公司信息技术管理部 吴保杰/林剑青

在金融科技迅猛发展的背景下,数据作为金融科技的核心基础,在国家层面数据作为基础性战略资源已成为整个社会的共识,2017年政府报告提出数字经济,2018年提出数字中国。证券行业的科技应用水平紧跟时代的步伐,进入了数字化转型加速期。

数字化的证券公司应当能够实时掌握全局动态、迅速响应市场变化。不论是客户偏好的分析、证券投资的研究,还是风险水平的监控,都离不开内外部各类数据的实时分析。大数据已成为重要的资产和生产资料,在推动业务创新和发展中起到重要作用。所以建设好企业的数据道路至关重要。

数据同步的难点

证券公司需要对历史数据进行快速统计、窗口时间内的信息流和触发事件,并具备模型匹配、百毫秒级事件响应等能力,以支持实时分析和实时风险预警等业务场景。这些都要求拥有更强大的数据流处理能力。

而在这之前,证券市场瞬息万变,资讯、行情、交易数据变化频繁(毫秒级)、数据量增长快,且数据种类繁多,也让整个数据同步过程困难重重:

难点1:数据多、增长快

证券公司每天需要面临大量种类繁杂的数据,包括内部的客户数据、交易数据、持仓数据,外部的行情数据、资讯数据、舆情数据等等,这些结构化以及非结构化数据的性质、格式各不相同,数据流处理方法也不尽相同,需要对各类数据进行分类,才能实现有效的传输。

难点2:同步数据质量保障

维克托·迈尔-舍恩伯格在其著作《大数据的时代》中所谈到“数据量的大幅增加会造成结果的不准确,一些错误的数据会混进数据库……”一旦数据质量受到影响,将影响数据分析模型的有效性,进而影响公司决策的准确性。在一些直接与投资决策相关的业务场景中,更有可能为公司带来巨额损失。所以为了避免数据在抽取、传输、脱敏的过程中造成的信息损失,在数据传输的过程中要保证数据验证性工作的充分介入,同时满足传输效率和数据质量之间的平衡。

难点3:历史底层架构局限

传统业务系统的底层数据管理系统多为Oracle、SQLServer、DB2等关系型数据库,处理效率存在瓶颈。通过提高主机的硬件能力来提升数据处理能力,必然导致成本投入的增加。而这些性能扩展成本高昂,边际效益递减。

随着创新型业务的不断发展,非结构化和半结构化数据的重要性逐渐凸显,而传统数据库无法支持这类数据的抽取、脱敏、分析。

数据同步的解决方案

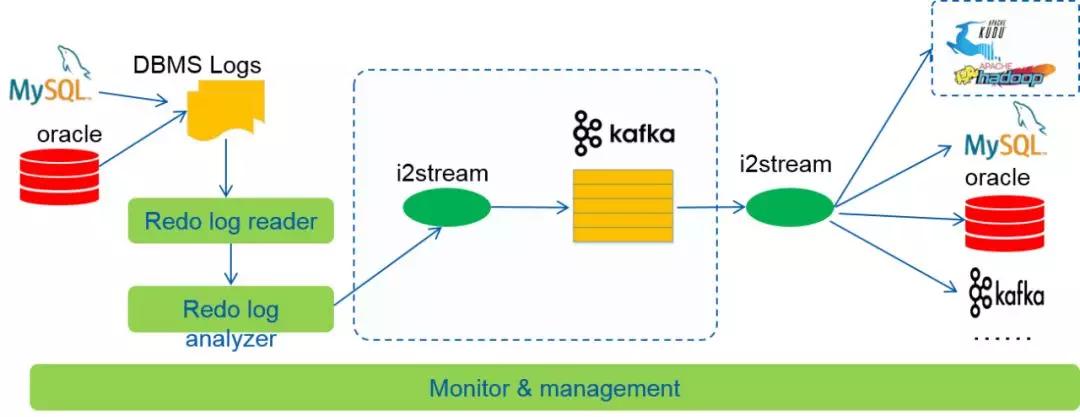

综上所述,海通引入了国内软件厂商英方软件自主研发的数据流同步工具,该工具基于数据共享技术,可实现多源异构环境下数据库之间的数据文件级、数据库级、Schema级、Table级的数据双向同步,实现数据的提取、复制、加载和管理,并且兼容hadoop大数据平台、Kafka分布式消息队列等,提供灵活、可靠的高可用性方案。该工具具有如下的特点:

1)实现了同构数据库之间各类数据库对象同步的解决方案,支持oracle到oracle,oracle到mysql,mysql到mysql, mysql到oracle等的对象同步,无侵入式抽取生产端redo log中的数据,目标端数据库打开状态,实现实时数据装载,支持视图、表、函数、索引、序列、存储过程、分区表、约束、同义词、触发器、队列、物化视图、权限,DB-LINK,JOB等的同步,实现数据库初始全量复制和增量数据无缝衔接的实时同步,同时数据延迟达到秒级,满足数据实时同步需求。

2)实现了数据库对象同步到Kafka中的解决方案,实现Kafka数据实时同步到传统关系型数据库中,同时装载到大数据平台模块中;同时支持灵活部署,实现数据的实时同步,时延达到秒级,满足业务的实时读取需求。

3)摒弃了JDBC连接数据库对数据库造成的压力,采用解析数据库Redo log日志的非侵入方式实现数据同步,对源数据库造成的压力极小,支持源端多线程抓取日志时并行加速功能,支持集群自适应多节点并发读取分析,实现了实时异步复制,只传输数据的变化量;可以满足多并发和高频次数据实时同步。

4) 数据同步工具亦提供目标端数据库接管和增量回切等高级功能,序列化传输保证数据的一致性,持续数据保护,可从任意故障点恢复数据状态;同时在复杂的应用环境下完成数据库的容灾保护、异构数据迁移、数据分发等数据整合工作。

5)提供统一的数据实时同步集中管理和监控功能,拥有友好的图形化管理界面,支持多种数据格式,具备异构灵活,迭代快速,部署方式简单等优势,丰富的规则设定使得系统的整体可用性得到很大的扩展,同时具备良好的容错处理机制,故障切换快捷简单;增量数据的差异化校验比对使得数据同步过程中数据质量得到有效地保障;邮件和短信告警机制保障出现问题的第一时间通知相关人员处理,同时提供巡检通知及整体状态通知。

基于以上,数据同步具体的做法是,首先确定需要同步的生产系统数据库类型和部署模式,通过部署数据同步工具,读取并解析数据库的Redo log将数据库数据实时同步到Kafka集群中,进而基于Kafka集群实现大数据的分析和应用。其次,通过数据实时同步工具的控制,可以实现Kafka数据实时同步到Mysql和Oracle等数据库中,并支持实时装载到大数据平台组件HDFS、hive、hbase、Kudu等模块中,为大数据批量处理、实时分析提供安全可靠的数据源。

数据同步后的应用场景

流水不腐,户枢不蠹。 数据通路一旦打通,让数据高效流 动起来,那么数据价值也就能够更好的凸显出来。典型的的应用场景有如下几种:

1) 数据管理:针对不同关系型数据库、Hadoop大数据平台、Kafka消息队列等异构数据源的实时同步,为用户提供灵活的数据源实时转化方式。

2) 数据应用:数据流的及时传输性,可以在精准营销、风险管控、决策分析、效率提升等业务场景实现业务分析系统的实时分析统计和监控。

3) 读写分离:针对同构关系型数据库,如oracle到oracle,mysql到mysql,sqlserver到sqlserver等,生产端数据写入,目标端数据查询,分担生产库压力,减轻生产库性能负载。

4) 数据冗余:实现数据的实时复制,源端受保护的数据产生变化时,软件捕获该变化数据并实时同步到目标端系统。如果当前最新数据受到损坏,可以将目标端数据恢复到历史时间点状态,保障业务连续的可持续性。可应用于普通文件系统、数据库系统、邮件系统、影像系统等实时的数据冗余保护。

小结

随着《证券基金经营机构信息技术管理办法》、《证券期货业数据分类分级指引》的发布,数据应用和安全工作重要性进一步凸显。《证券基金经营机构信息技术管理办法》不仅明确了数据治理的要求,也提出了数据应用的要求——“证券基金经营机构应当充分挖掘、梳理和分析数据内容,提高管理精细化程度,在业务经营、风险管理与内部控制中加强数据应用,实现同一客户、同类业务统一管理,充分发挥数据价值。”

从证券公司自身发展的角度来说,数据的基础设施建设是一切上层应用的基础,也是推动数字化转型的必要条件。通过数据的有效抽取、同步等,打通横向纵向的数据流、信息流、业务流,更快速、更全面、更准确地了解企业自身的各个环节并获得决策洞察,提升决策效率,快速响应市场变化,持续推进数字化转型。

容灾产品

容灾产品 备份产品

备份产品 大数据产品

大数据产品 云灾备产品

云灾备产品 统一数据管理平台

统一数据管理平台

沪公网安备 31010102007307号

沪公网安备 31010102007307号